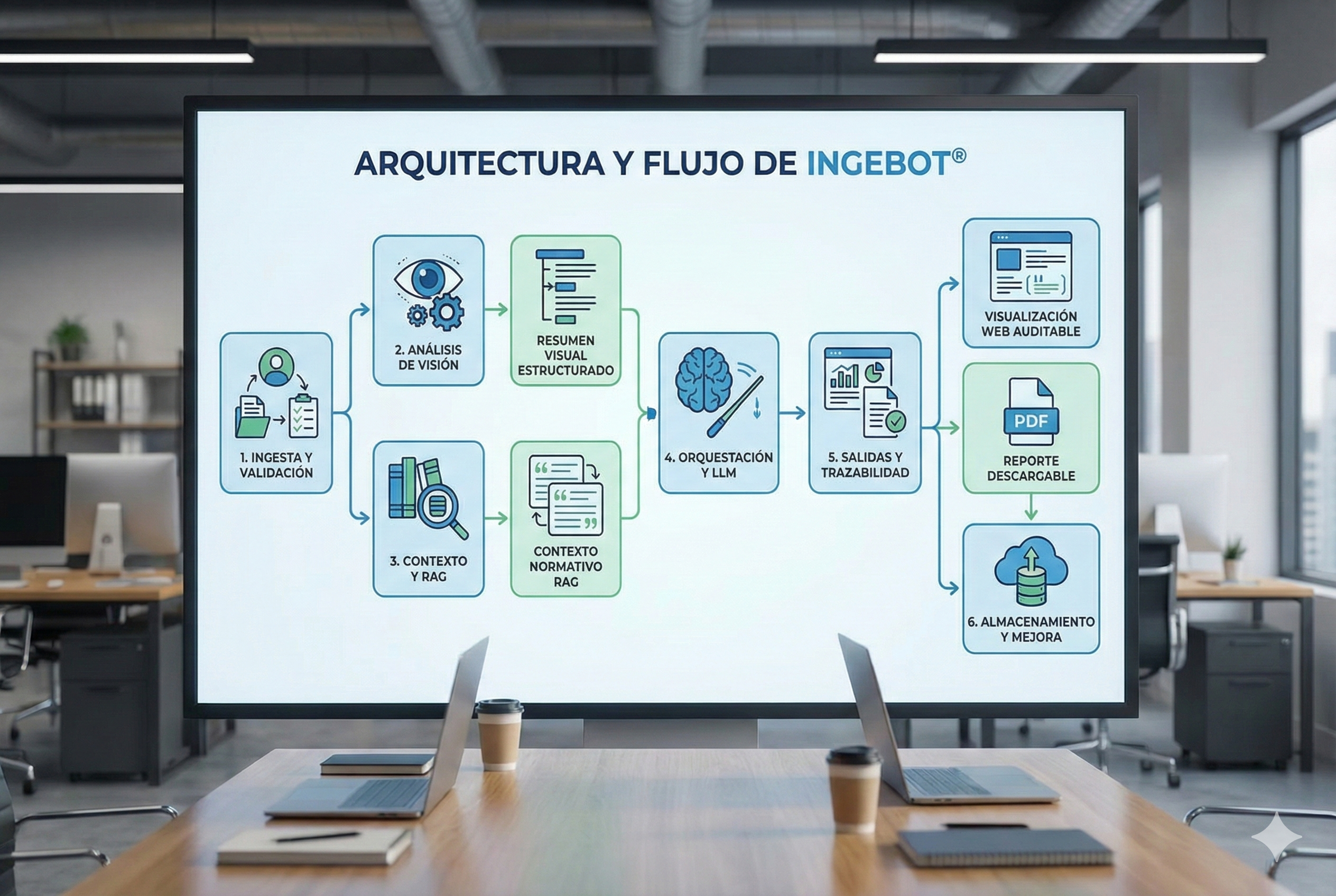

Conoce cómo trabaja IngeBot tras bambalinas

Arquitectura y flujo de IngeBot

IngeBot combina un modelo de visión para interpretar imágenes técnicas con un modelo avanzado de lenguaje que redacta hallazgos claros. Todo se orquesta con un flujo RAG para sumar contexto normativo y conocimiento propio antes de generar cada respuesta.

1. Ingesta y validación

El usuario carga imágenes (tableros, mallas, instalaciones). Se validan formatos y tamaño, y se limpian los metadatos sensibles. Los datos del proyecto (país, sector, disciplina, fase) se normalizan para que el flujo use claves consistentes.

2. Análisis de visión

Las imágenes pasan a un modelo de visión que extrae señales técnicas (equipos, conductores, etiquetas, tableros). El resultado se resume en texto estructurado que servirá como evidencia de entrada.

3. Contexto y RAG

Con los datos del usuario, se consulta una base de conocimiento (normas, criterios internos y guías) usando búsqueda semántica. Se seleccionan los fragmentos más relevantes y se citan. Esto forma el contexto RAG que acompaña al modelo de lenguaje.

4. Orquestación y respuesta

El modelo de lenguaje recibe: resumen visual, contexto RAG y las preguntas del usuario. Se le pide responder con trazabilidad (referencias a las fuentes recuperadas) y con recomendaciones accionables.

5. Salidas y trazabilidad

El resultado se presenta en bloques: hallazgos, referencias normativas y sugerencias. Las citas permiten auditar qué parte del conocimiento se usó. Cuando el usuario descarga, se genera un reporte listo para compartir.

6. Almacenamiento y mejora

Cada interacción guarda un registro mínimo en la base de datos para trazabilidad y mejoras futuras. No se almacenan imágenes ni textos sensibles más allá de lo necesario para la sesión de análisis.

¿Quieres probar IngeBot con tus propios casos?

Ir al IngeBot